E’ agosto e mentre noi ci prendiamo le ferie il mondo dell’intelligenza artificiale sta vivendo un momento di accelerazione straordinaria.

Qui vi parlo del lancio delle innovazioni da parte dei principali attori del settore: OpenAI, xAI e Anthropic, l’ultimo dei quali fa il vero salto quantico. Vedremo anche le risposte di Google e DeepSeek. Ogni azienda ha scelto una strategia diversa, ma tutte spinte dalla concorrenza a dare di più.

OpenAI e GPT-5: Quando la Trasparenza Diventa Spettacolo

OpenAI ha rilasciato GPT-5 il 7 agosto 2025, rendendolo accessibile fin da subito come opzione predefinita per tutti gli utenti, anche quelli che usufruiscono del servizio gratuitamente.

GPT-5 integra un sistema che decide in autonomia se fornire una risposta rapida o se “prendersi del tempo per pensare”, scegliendo l’approccio migliore per ogni richiesta senza che l’utente debba modificare alcuna impostazione.

Questa funzionalità trasforma quello che era un processo noioso in una vera e propria esperienza visiva.

Il ‘giochino di animazione’ di GPT-5 mostra all’utente esattamente come arriva alle sue conclusioni, rappresentando un perfetto esempio di gamification applicata all’AI: l’intrattenimento visivo compensa i tempi più lunghi necessari per il ragionamento.

Caratteristiche chiave di GPT-5:

- Ragionamento trasparente: mostra il processo di pensiero in tempo reale;

- Riduzione delle allucinazioni: circa dell’80% inferiore di errori fattuali rispetto a o3;

- Accessibilità totale: disponibile gratuitamente per tutti gli utenti.

Grok4: La Sfida di Elon Musk

xAI ha lanciato Grok 4 il 10 luglio 2025, e Musk lo ha presentato nel suo inconfondibile stile di affermazioni audaci: “l’intelligenza artificiale più intelligente al mondo”.

Le principali innovazioni di Grok4:

Sistema Multi-Agente con Grok 4 Heavy

E’ un approccio collaborativo e rappresenta una novità assoluta nel settore, perché permette a diversi “cervelli artificiali” di lavorare insieme su problemi complessi. In Italia, SuperGrok Heavy costa 349€ al mese, il prezzo più elevato tra le soluzioni IA consumer ad oggi.

Prestazioni da Record

Ovviamente i risultati sui benchmark sono impressionanti:

- Humanity’s Last Exam: outperforming Google’s Gemini 2.5 Pro and OpenAI’s o3 (high)

- ARC-AGI-2: il risultato di 16.2% è quasi il doppio del migliore modello commerciale di AI

Produzione di Immagini

Anche Grok 4, come SORA o VEO è in grado di produrre immagini e video, questi ultimi però solo attraverso abbonamenti premium.

Anthropic e Claude: Il Vero Salto Quantico

Ma il vero “salto quantico” lo fa Anthropic. Claude che ora ha la capacità di ritrovare e referenziare le chat precedenti risolve quello che era il limite più frustrante di tutti i chatbot AI: la perdita di memoria conversazionale.

Fine del Limite Fisico!

Tradizionalmente, ogni conversazione con un AI ha un limite massimo di token (parole) che può processare e che, una volta raggiunto, richiede di ricominciare da capo perché il modello “dimentica” l’inizio della conversazione.

Beh, adesso Claude non ha più questo problema perché può accedere a tutta la storia delle conversazioni passate:

- Ricordare progetti sviluppati in conversazioni precedenti

- Mantenere il contesto di discussioni complesse sviluppate in sessioni multiple

- Continuare analisi iniziate settimane o mesi prima

- Costruire una vera “memoria di lavoro” a lungo termine

Questa funzionalità trasforma Claude in un vero assistente personale, in grado di mantenere il filo del discorso e l’evoluzione del pensiero dell’utente nel tempo.

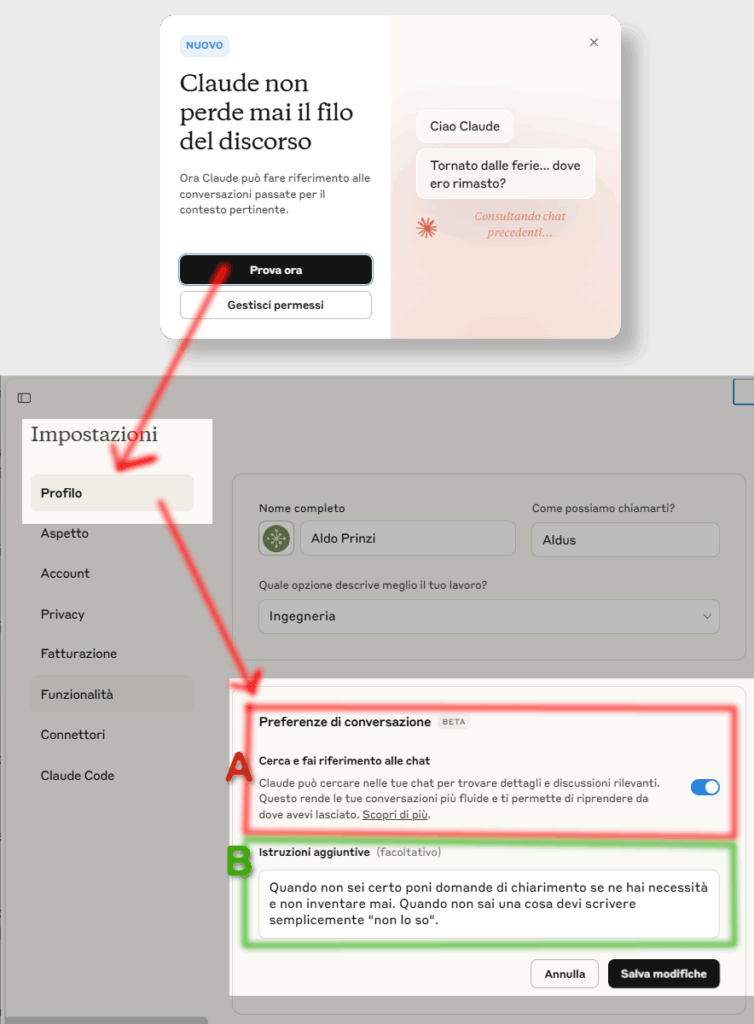

A) Quando aprite Claude vi viene chiesto se lo volete autorizzare a leggere le vecchie/altre conversazioni.

B) Questo è il mio segreto per evitare le “allucinazioni” del modello (come per GPT-5 rispetto GPT-o3 😎).

Google/Gemini

Google è rimasta a guardare? Le risposte significative presentate al Google I/O 2025 e implementate durante l’estate si concentrano su tre pilastri: sistemi multi-agente, capacità agentiche e integrazione profonda nell’ecosistema Google.

Gemini 2.5 Deep Think: Il Sistema Multi-Agente

Il 1° agosto 2025, Google ha rilasciato Gemini 2.5 Deep Think, il suo primo sistema multi-agente che, come xAi-Grok4-Heavy genera multipli agenti AI per affrontare una domanda in parallelo, un processo che utilizza significativamente più risorse computazionali di un singolo agente, ma tende a produrre risposte migliori.

La caratteristica più interessante di Deep Think è che è capace di produrre “risposte molto più lunghe” rispetto agli altri prodotti di AI in commercio.

Infine una nota importante per chi fa commercio elettronico, viene introdotto lo Shopping agentico: funzionalità di checkout automatico che effettua acquisti quando il prezzo è giusto

E DeepSeek?

Nel 2025 è emerso un protagonista inaspettato che ha scosso le fondamenta dell’industria AI: DeepSeek, un laboratorio di ricerca cinese che ha dimostrato come l’innovazione possa nascere da limitazioni apparenti.

Il modello è 100% gratuito in chat e poco costoso via API, si distingue per diverse caratteristiche innovative. Al momento in cui scrivo questo articolo non ci sono speciali annunci o rilasci in risposta alle mosse dei “concorrenti”.